La mémoire, pilier des expériences IA sur smartphone

Depuis quelques années, l’industrie du smartphone ne cesse de vanter les prouesses de l’intelligence artificielle embarquée. À chaque sortie de processeur, les fabricants rivalisent d’arguments pour souligner la capacité de leurs puces à exécuter localement des algorithmes de génération vidéo, de reconnaissance vocale ou de retouche d’images. Pourtant, derrière ces démonstrations spectaculaires et parfois gadget, la réalité technique reste souvent méconnue: au‑delà de la puissance de calcul, c’est la mémoire vive et le stockage qui déterminent en grande partie les performances effectives des fonctions IA sur mobile.

Le grand public a pris conscience de cet enjeu lors de la sortie du Pixel 8 de Google, privé de « Gemini Nano » en raison d’une configuration mémoire jugée insuffisante. Apple a rapidement suivi en réservant son offre « Apple Intelligence » aux iPhone dotés d’au moins 8 Go de RAM. Mais la quantité de mémoire ne suffit pas à elle seule. Les optimisations internes de la RAM, ainsi que les caractéristiques des modules de stockage UFS, jouent un rôle tout aussi vital pour garantir la fluidité et la réactivité des applications d’IA.

C’est dans cette optique que Micron, l’un des leaders mondiaux de la mémoire et du stockage, a développé deux nouveautés majeures destinées aux smartphones haut de gamme: les puces de mémoire vive LPDDR5X « 1 γ » et les solutions de stockage G9 NAND UFS 4.1. Ces modules offrent non seulement des capacités accrues, mais aussi des débits et des latences optimisés pour soutenir les charges intensives imposées par l’IA embarquée.

Les premiers tests autour du G9 NAND UFS 4.1 révèlent une bande passante maximale de 4 100 Mo/s en lecture et écriture séquentielles, soit un gain de 15 % par rapport à la génération précédente. Cette amélioration s’accompagne d’une réduction de la latence, essentielle pour des accès rapides aux poids et instructions des modèles d’IA stockés localement. Cerise sur le gâteau, Micron parvient à proposer ces puces jusqu’à 2 To tout en réduisant leur encombrement, ce qui en fait un choix parfait pour les smartphones pliants ou les modèles ultra‑fins tels que le futur Galaxy S25 Edge.

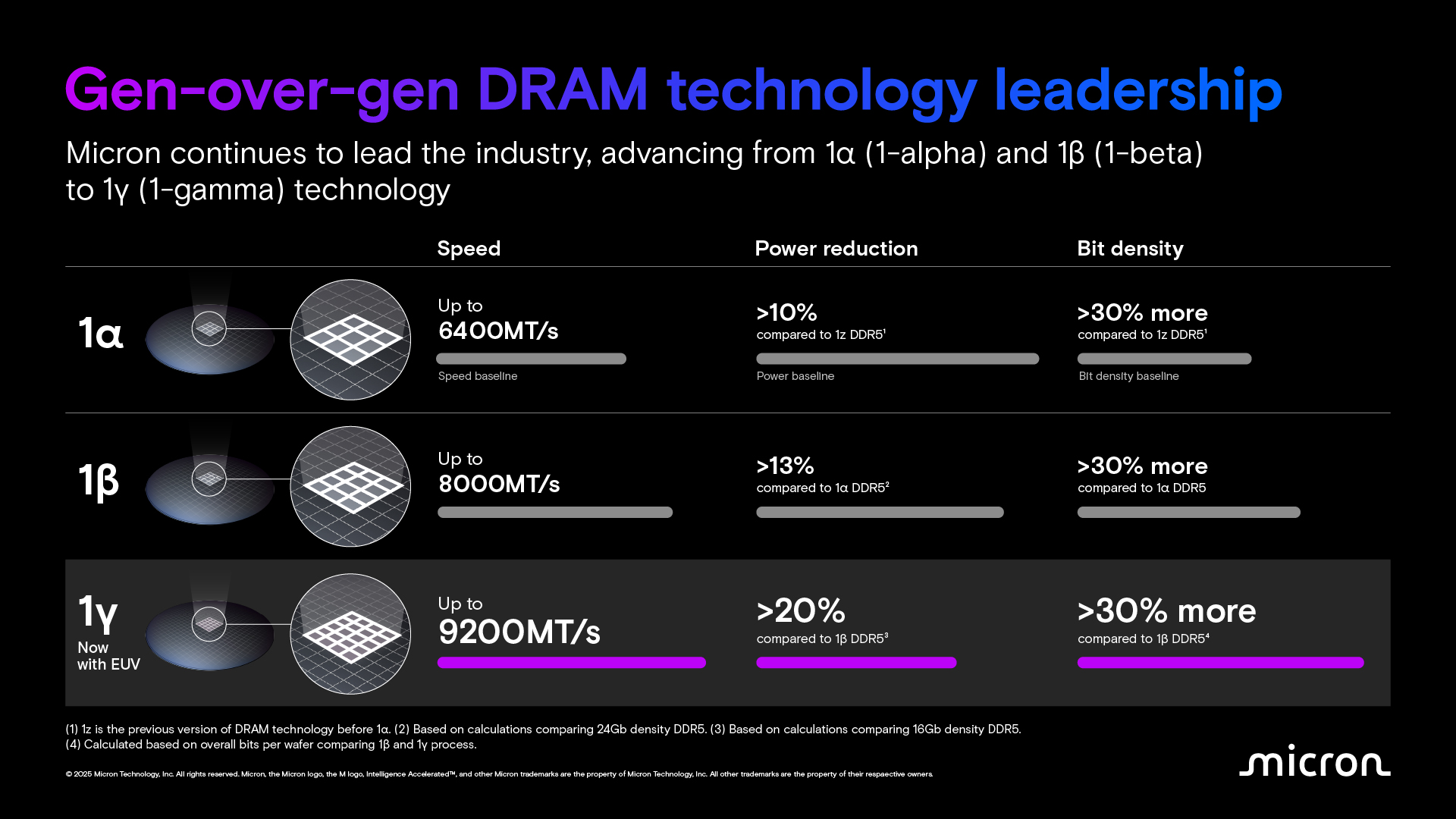

Côté RAM, la série 1 γ atteint des débits de 9 200 MT/s, une hausse importante par rapport aux solutions « 1 β » déjà intégrées dans la gamme Galaxy S25. La densité transistorique a progressé de 30 % grâce à un processus de gravure affiné, tandis que la consommation s’en trouve diminuée de 20 %. Conjuguées à un voltage de fonctionnement abaissé, ces puces délivrent une performance énergétique optimisée, critère déterminant pour des usages prolongés d’IA sans mettre à mal l’autonomie.

Mais au‑delà des chiffres bruts, c’est l’interaction intelligente entre stockage et mémoire vive qui fait toute la différence. Quatre innovations de la marque méritent une attention particulière: Zoned UFS, Data Defragmentation, Pinned WriteBooster et Intelligent Latency Tracker. Chacune répond à un défi précis pour fluidifier l’échange des données lors de l’exécution des modèles directement sur le smartphone. Le Pinned WriteBooster, par exemple, identifie dans un tampon à haute vitesse les données les plus fréquemment sollicitées par l’IA, accélérant ainsi leur accès de 30 %. Imaginons que Gemini doive analyser un document PDF, seules les parties du réseau de neurones nécessaires sont transférées du stockage vers la RAM, sans perturber les autres applications en arrière‑plan.

Data Defragmentation, quant à elle, réorganise périodiquement les blocs de données pour éviter la dispersion sur la puce de stockage. À force d’écritures et de suppressions, les informations se retrouvent souvent fragmentées, obligeant le contrôleur à multiplier les recherches. En restructurant ces blocs, Micron annonce un gain de 60 % sur la vitesse de lecture, bénéfique non seulement aux tâches IA mais aussi à la réactivité générale du système. L’Intelligent Latency Tracker, de son côté, surveille en temps réel les événements de latence, permettant de diagnostiquer et de corriger automatiquement les goulets d’étranglement. Enfin, le Zoned UFS organise les données de même nature I/O dans des zones dédiées, réduisant le temps de localisation lors des requêtes. Ensemble, ces technologies composent un écosystème mémoire pensé pour les usages IA de demain.

Au‑delà de la quantité, c’est donc la qualité et l’efficience des modules mémoire qui détermineront l’expérience utilisateur. Si Apple a fixé la barre à 8 Go de RAM, de nombreux constructeurs Android visent désormais 12 Go comme minimum. Avec ses LPDDR5X 1 γ, Micron propose même des modules capables d’atteindre 9,6 Gbit/s tout en tirant profit des dernières avancées en lithographie EUV pour offrir 20 % d’efficacité énergétique en plus. Alors que la tendance se tourne vers l’IA entièrement locale (minimisant les allers‑retours vers le cloud pour une meilleure confidentialité et une latence réduite) les innovations mémoire deviennent indispensables. Qu’il s’agisse de transcrire un appel, d’analyser un PDF ou de générer une image à partir d’un simple texte, le smartphone doit embarquer des composants capables d’assurer des échanges de données ultra‑rapides et peu gourmands en énergie.

D’après Micron, les premiers flagships équipés de ces nouvelles puces devraient arriver sur le marché fin 2025 ou début 2026. En attendant, gardez un œil sur les annonces des grands fabricants, la promesse d’une IA mobile enfin performante et respectueuse de votre vie privée pourrait bien devenir réalité très bientôt.